如何通过重复进行评估

运行多次重复可以更准确地估计系统的性能,因为 LLM 输出不是确定性的。输出可能因重复而异。重复是减少 易发生高可变性的系统中的噪声,例如代理。

在实验中配置重复项

添加可选的num_repetitionsparam 添加到evaluate / aevaluate函数 (Python, TypeScript) 指定多少次

对数据集中的每个示例进行评估。例如,如果数据集中有 5 个示例,并且将num_repetitions=5,每个示例将运行 5 次,总共运行 25 次。

- 蟒

- TypeScript (类型脚本)

from langsmith import evaluate

results = evaluate(

lambda inputs: label_text(inputs["text"]),

data=dataset_name,

evaluators=[correct_label],

experiment_prefix="Toxic Queries",

num_repetitions=3,

)

import { evaluate } from "langsmith/evaluation";

await evaluate((inputs) => labelText(inputs["input"]), {

data: datasetName,

evaluators: [correctLabel],

experimentPrefix: "Toxic Queries",

numRepetitions=3,

});

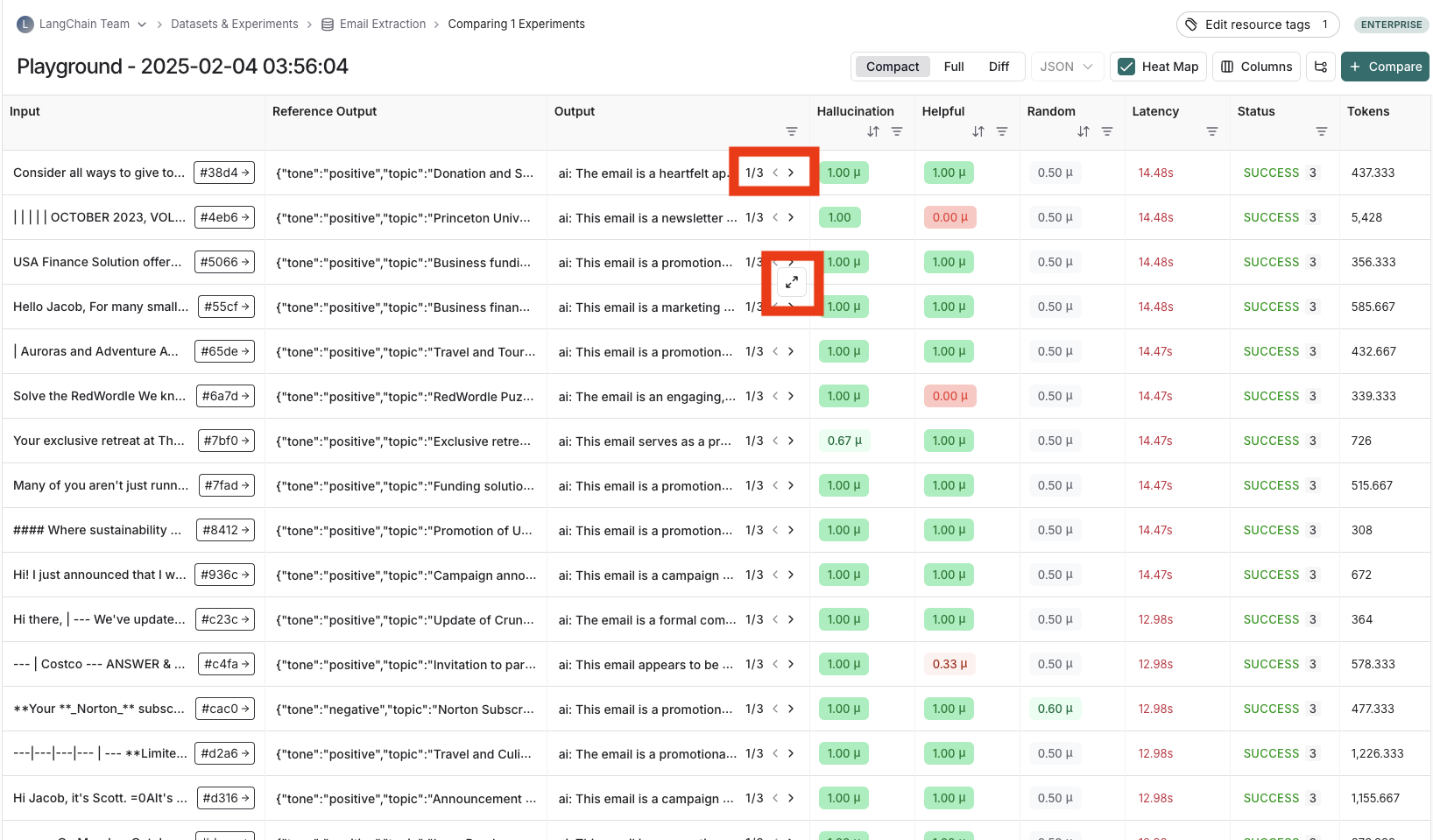

查看使用 repeitions 运行的实验的结果

如果您已使用重复项运行实验,则 output results (输出结果) 列中将有箭头,以便您可以在表中查看输出。要查看重复项中的每个运行,请将鼠标悬停在输出单元格上,然后单击展开的视图。 当您运行重复项试验时,LangSmith 会在表中显示每个反馈分数的平均值。单击反馈分数可查看单个运行的反馈分数,或查看重复项的标准差。